Nell’ultimo decennio, le corti statunitensi sono state chiamate a decidere numerose controversie legate all’utilizzo di sistemi di Intelligenza Artificiale (IA) da parte delle pubbliche amministrazioni. Questo articolo contribuisce alla discussione sull’utilizzo governativo dell’IA fornendo una panoramica dei contenziosi ad esso correlati negli Stati Uniti. L’analisi conduce a una principale conclusione, ossia che le decisioni giudiziarie si basano quasi esclusivamente su presupposti procedurali, in particolare quelli riguardanti violazioni della “due process clause”, suggerendo quindi che le problematiche sostanziali sono tipicamente affrontate attraverso soluzioni di tipo procedurale. A loro volta, questi elementi procedurali consistono in sei violazioni: mancanza di comunicazioni e motivazioni idonee, mancanza di rimedi di contestazione effettivi, indisponibilità delle informazioni, mancanza di meccanismi di supervisione umana, mancato rispetto delle procedure di notice-and-comment, e mancanza di idonee procedure di assessment. Rivelando questa tendenza e identificando le sei violazioni procedurali, l’analisi fornisce una tassonomia dei requisiti minimi che ogni ente governativo statunitense dovrebbe rispettare per far sì che l’utilizzo dei sistemi di IA superino il vaglio giurisprudenziale.

What do U.S. courts say about the use of AI?

In the last decade courts across the U.S. have decided cases related to the use of AI by governmental bodies. This paper provides a quantitative and qualitative study of how courts deal with litigation on the use of AI by governmental bodies. The analysis leads to an overarching conclusion, namely, that judicial decisions almost exclusively rely on procedural grounds – specifically those concerning due process infringements – thus suggesting that substantial issues are typically addressed through procedural solutions. In turn, these procedural issues consist of six violations: lack of adequate notice and explanation, lack of contestability, lack of human oversight, lack of notice and comment procedures, lack of assessment procedures, and denial of the right to access information. By revealing this tendency and by identifying the six procedural violations, the analysis ultimately provides a taxonomy of the minimum requirements that any governmental body should comply with to shield their use of algorithmic systems from judicial review in the US.

1. Introduzione

L’avvento dell’intelligenza artificiale promette un aumento di efficienza, benefici organizzativi e una riduzione dei costi per le amministrazioni pubbliche[1]. Gli enti governativi a livello globale si affidano sempre di più all’intelligenza artificiale (IA) per gestire funzioni pubbliche in un’ampia varietà di contesti[2]. Oggi, negli Stati Uniti, i sistemi di IA aiutano le amministrazioni statali e federali ad erogare prestazioni e servizi, inclusa l’allocazione di benefici economici, alimentari e socioassistenziali, distribuire risorse pubbliche e supportare attività di enforcement. Tuttavia, l’IA nasconde una serie di rischi, tra cui discriminazioni di genere, razziali e socioeconomiche[3].

Questi effetti potenzialmente dannosi non sono passati inosservati negli Stati Uniti, dove si sono registrati importanti progressi nel rispondere a queste preoccupazioni attraverso l’elaborazione di documenti di indirizzo volti a stabilire principi generali per lo sviluppo e l’utilizzo di sistemi di IA. Nel 2020, l’Executive Order “Promoting the Use of Trustworthy Artificial Intelligence in the Federal Government” ha delineato nove principi finalizzati ad accrescere la fiducia pubblica sull’utilizzo dell’IA da parte delle agenzie federali nell’esercizio delle rispettive funzioni[4]. Nel 2022, la Casa Bianca ha rilasciato il “Blueprint for an AI Bill of Rights”, un documento di indirizzo volto a fornire indicazioni pratiche per mitigare i potenziali danni derivanti da alcuni utilizzi dell’IA, rivolto sia alle agenzie governative che alle società private operanti nel settore[5]. Da ultimo, nell’ottobre 2023 il Presidente Biden ha emanato l’Executive Order 14,110 “Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence”, che individua una serie di misure finalizzate alla protezione dei civil rights e alla promozione dell’eguaglianza nell’utilizzo dei sistemi di IA da parte del governo federale[6].

In attesa di un assestamento del quadro regolatorio, le corti statunitensi sono state chiamate a risolvere controversie riguardanti l’effettivo utilizzo dei sistemi algoritmici sia nel settore pubblico che privato. Negli ultimi anni, settori come l’erogazione di prestazioni e servizi pubblici, l’allocazione di benefici economici, l’istruzione, l’intermediazione immobiliare e la giustizia penale hanno visto un aumento dei contenziosi legati all’utilizzo di sistemi di IA[7]. Questo articolo contribuisce alla discussione sull’utilizzo governativo dell’IA fornendo una panoramica del contenzioso negli Stati Uniti. Attraverso un’analisi sistematica di come le corti statunitensi affrontano le controversie sull’uso dell’IA da parte degli enti governativi americani, questo contributo valuta la presenza di modelli e tendenze comuni nelle decisioni giurisdizionali e analizza l’approccio interpretativo utilizzato dalle corti statunitensi quando parte della controversia è una pubblica amministrazione. Nel fare ciò, l’articolo fornisce una tassonomia dei requisiti minimi che ogni ente governativo statunitense dovrebbe rispettare per far sì che l’utilizzo dei sistemi di IA superino il vaglio giurisprudenziale. In chiave comparata, l’approccio concreto e casistico delle corti statunitensi fornisce importanti indicazioni per il dibattito europeo sulla regolazione dell’IA[8].

Il contributo è diviso in due parti. Basandosi su un campione di 128 casi, la prima parte si sofferma sulle differenze tra controversie fra privati e controversie rivolte contro una pubblica amministrazione per mostrare il diverso andamento nel tempo, nonché alcuni aspetti processuali, tra cui il ruolo delle azioni collettive. La seconda parte procede quindi con un focus su 44 casi che coinvolgono le amministrazioni pubbliche, fornendo un’analisi ragionata degli orientamenti giurisprudenziali nelle principali aree di contenzioso, nonché delle implicazioni riguardanti il ruolo regolativo svolto dalle corti statunitensi con riguardo all’effettivo utilizzo dell’IA nel settore pubblico.

2. Note di metodo

Per indagare l’approccio interpretativo adottato dalle corti statunitensi per risolvere le controversie legate all’utilizzo dell’IA, ho analizzato una selezione di casi decisi dalle corti statali e federali a partire dal 2010. Il campione di casi è stato selezionato attraverso due principali banche dati: l’AI Litigation Database, sviluppato dalla George Washington University, che fornisce un campione di 91 casi[9], e l’AIAAIC Repository (AI, Algorithmic, and Automation Incidents and Controversies), che ha permesso di includere ulteriori 37 casi[10]. Combinando i dati di entrambi i database, è stato possibile costruire un campione complessivo di 128 casi. Questi due database rappresentano attualmente la più estensiva raccolta di casi giudiziari riguardanti l’utilizzo dell’IA nel panorama statunitense[11].

Prima di procedere, è utile precisare che il campione di dati utilizzato non è rappresentativo della totalità delle controversie legate all’utilizzo dell’IA negli Stati Uniti. La completezza dei database è limitata dall’assenza di un sistema di catalogazione automatizzato, essendo affidata ad una sistema di raccolta dei casi prevalentemente manuale. Inoltre, molte controversie legate all’utilizzo dell’IA trovano spesso soluzioni stragiudiziali o non sono oggetto di un’azione giudiziaria di fronte a una corte statale o federale. Nondimeno, il campione di casi consente di evidenziare gli orientamenti giurisprudenziali prevalenti nelle principali aree di contenzioso, fornendo una base dati solida per l’analisi delle principali tendenze interpretative e delle implicazioni legali connesse all’uso dell’IA. In aggiunta, il campione include sia controversie concluse che in corso di svolgimento[12]. Ne discende che per alcune controversie sono disponibili solo provvedimenti interinali, come court orders o preliminary injunctions. In altri casi, i dati raccolti si basano su decisioni non definitive e, per le controversie più recenti, le informazioni possono essere del tutto assenti. Infine, il campione include anche controversie giudiziarie concluse mediante la stipula di accordi transattivi (settlement agreements).

3. Casi selezionati

Il campione di dati può essere suddiviso in due macrocategorie: controversie tra soggetti privati e controversie rivolte contro una pubblica amministrazione.

Tabella I: Divisione del campione di casi.

| Casi Privati | 84 | Casi Pubblici | 44 | |

| IA Generativa | 18 | Accesso a prestazioni | 7 | |

| Dati biometrici | 24 | Identificazioni frodi | 6 | |

| Veicoli autonomi | 8 | Attività di enforcement | 27 | |

| Usi discriminatori | 17 | Altri usi | 4 | |

| N/A | 17 | N/A | 0 |

Le 84 controversie tra privati sono state classificate in quattro sub-categorie: (i) violazioni in materia di privacy o proprietà intellettuale connesse all’utilizzo dell’IA Generativa; (ii) raccolta ed utilizzo illegittimo di dati biometrici; (iii) richieste di risarcimento per incidenti causati da veicoli a guida autonoma; (iv) utilizzo dell’IA con effetti discriminatori nell’ambito di processi di assunzione dei lavoratori, selezione degli affittuari o nella gestione dei prodotti finanziari. I restanti 44 casi riguardano l’impiego dell’IA da parte di autorità governative federali, statali o locali per l’esercizio delle rispettive funzioni. Anche in questo caso è stato possibile raggruppare le controversie in quattro principali sub-categorie: (i) utilizzo dei sistemi di IA per l’allocazione di risorse pubbliche e l’erogazione di prestazioni e servizi; (ii) l’utilizzo di sistemi di IA per l’identificazione di frodi nella richiesta di sussidi pubblici e benefici economici; (iii) utilizzo di sistemi di IA a supporto delle attività di attività di contrasto e polizia; (iv) altre tipologie di utilizzo, quali ad esempio, l’impiego di sistemi di IA per adottare decisioni riguardanti i rapporti di lavoro degli impiegati pubblici.

Come anticipato nell’introduzione il contributo si concentra sui casi che coinvolgono la pubblica amministrazione. Da un lato, infatti, l’analisi mira a contribuire alla discussione sull’impiego di sistemi di IA da parte delle amministrazioni pubbliche fornendo una panoramica completa e sistematica degli orientamenti interpretativi adottati dalle corti statunitensi per risolvere le controversie legate all’utilizzo dei sistemi di IA per l’esercizio di funzioni pubbliche. Dall’altro lato, i casi fra privati coinvolgono principalmente controversie legate a violazioni in materia di privacy o proprietà intellettuale, alla raccolta ed utilizzo illegittimo di dati biometrici o a richieste di risarcimento per incidenti causati da veicoli a guida autonoma. Di conseguenza, questo sottogruppo di casi non è strettamente correlato alla legittimità dell’uso dei sistemi di IA come strumenti di ausilio o supporto delle attività decisionali[13], ma riguarda altre e diverse problematiche giuridiche connesse al rispetto della normativa in materia di privacy e utilizzo di dati biometrici, alla disciplina in materia di proprietà intellettuale e diritto d’autore, nonché alle disposizioni concernenti il settore della responsabilità civile[14].

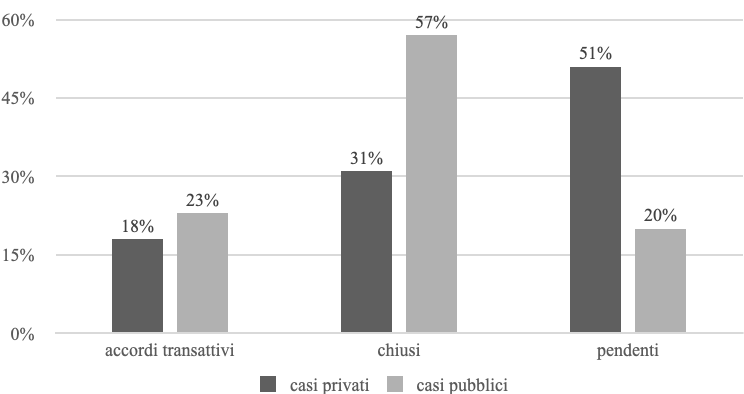

Inoltre, mentre le controversie contro la pubblica amministrazione incluse nel campione risultano già prevalentemente definite (80%), la maggioranza dei casi tra privati (51%) è ancora in corso di svolgimento, molte delle quali avviate solo di recente, determinando una base dati carente delle informazioni necessarie per poter analizzare gli approcci interpretativi impiegati dalle corti. A ciò si aggiunge, come meglio evidenziato di seguito, che una parte delle controversie fra privati è definita tramite accordi stragiudiziali coperti da clausole di riservatezza o non formalmente comunicati alle corti, limitando ulteriormente i margini per un’analisi delle tendenze giudiziarie nei casi fra privati.

Nondimeno, per evidenziare alcune differenze tra i casi che coinvolgono la pubblica amministrazione da quelli in cui le parti sono private, il paragrafo successivo offre una panoramica sull’andamento nel tempo delle controversie. La seconda parte approfondisce alcuni aspetti processuali, in particolare lo stato dei giudizi, distinguendo tra casi definiti con accordo transattivo, quelli conclusi, e quelli ancora in corso di svolgimento. Da ultimo, evidenzio alcune tendenze associate alle azioni collettive e al ruolo svolto da gruppi di advocacy.

3.1. Andamento delle controversie nel tempo

Figura 1 – Casi pubblici e privati (2010-2023).

La Figura 1 evidenzia che, mentre le controversie instaurate contro la pubblica amministrazione tendono a diminuire nel corso del tempo, le controversie fra i privati mostrano una crescita significativa a partire dal 2020, con un secondo picco nel 2023. Il primo aumento (2020) è attribuibile alla crescente enfasi posta a livello statale e locale sull’introduzione di misure volte alla limitazione nella raccolta e conservazione dei dati biometrici. Questa ipotesi è supportata dai dati analizzati, con un totale di 12 giudizi presentati contro Clearview AI solamente nel corso del 2020[15]. In tutte queste controversie, le parti ricorrenti allegano l’illegale acquisizione, conservazione, distribuzione di dati biometrici da parte di Clearview AI, in violazione del Biometric Information Privacy Act (BIPA) emanato dallo Stato dell’Illinois[16]. Il BIPA, infatti, stabilisce che ogni ente privato prima di procedere alla scansione, raccolta o trasmissione di dati biometrici debba ottenere il preventivo rilascio del consenso informato da parte degli interessati. Nel frattempo, cause simili sono state intentate nei confronti di altre società come Amazon, Apple, Walgreens, e McDonald’s[17] – le controversie che allegano violazioni del BIPA, istaurate tra il 2020 ed il 2021, costituiscono il 23% del campione dei casi fra privati.

Il secondo picco di casi è attribuibile alla diffusione di forme di IA generativa nel corso del 2023. Solamente nel corso dell’anno sono state presentate 8 class actions nei confronti di OpenAI, allegando l’illegittima raccolta ed utilizzo di dati per lo sviluppo di tecnologie basate sulla IA generativa (ChatGPT 3.5. – 4.0)[18]. Queste controversie, insieme ad altre contro Meta Platforms e Alphabet per la violazione del diritto d’autore[19], costituiscono il 23% del campione dei casi privati nel 2023.

Una dimensione non pienamente catturata dalla Figura 1 è la frequenza con cui queste controversie vengono promosse in un medesimo arco temporale. Spesso i giudizi contro lo stesso sistema algoritmico impiegato da amministrazioni pubbliche o enti privati vengono avviate contemporaneamente. L’impatto mediatico, unito agli sforzi dei gruppi di advocacy, favorisce un effetto a catena, portando all’insorgere di controversie simili in tutto il Paese[20]. Nel settore pubblico due esempi emblematici riguardano i giudizi promossi contro l’utilizzo del software EVAAS (Education Value-Added Assessment System) per la valutazione degli insegnanti impiegati presso istituti scolastici pubblici[21], e l’utilizzo di risk assessment systems per determinare la pericolosità sociale o il rischio di recidiva, come COMPAS[22]. Esempi simili sono rinvenibili anche nelle dispute fra privati, come nei casi già citati riguardanti Clearview AI e Open AI, così come nelle controversie legate alle selezione di potenziali affittuari promosse contro società di intermediazione immobiliare come CoreLogic, SafeRent[23] e RealPage[24].

3.2. Aspetti processuali

Figura 2 – Fase della controversia, casi pubblici e privati.

La Figura 2 mostra che più del 50% dei casi fra privati è in corso di svolgimento. Questo trend è principalmente influenzato da un effetto di composizione del campione, determinato dal crescente numero di controversie fra privati instaurate a partire dal 2020. Come visto, negli ultimi anni si è assistito ad un declino dei casi pubblici rispetto ai casi privati (Figura 1), tale da comportare la conseguente riduzione dei casi pubblici attualmente pendenti. Vi è una differenza anche nella proporzione di casi chiusi: i casi pubblici superano il 50%, mentre quelli privati si attestano intorno al 31%[25]. Da ultimo, la Figura 2 mostra che le controversie definite con accordo transattivo sono poco più frequenti nei giudizi in cui è parte l’amministrazione pubblica (23%) rispetto a quelli fra privati (18%).

Tuttavia, un’analisi più approfondita rivela che una parte delle controversie fra privati[26] viene definita a seguito della presentazione da parte del ricorrente di una notice of voluntary dismissal without prejudice (rinuncia volontaria). Una spiegazione plausibile è che le parti hanno raggiunto un accordo stragiudiziale che non viene formalmente comunicato alla corte. Inoltre, mentre gli accordi stragiudiziali tra i privati non vengono di norma resi pubblici e sono spesso coperti da clausole di riservatezza[27], gli accordi transattivi nei casi di cui è parte l’amministrazione sono generalmente pubblici e soggetti alla supervisione dell’organo giurisdizionale per garantire il monitoraggio dello sviluppo di nuovi sistemi di IA emendati dalle violazioni riscontrate nel corso del giudizio, l’introduzione di parametri procedimentali o criteri funzionali, e il coinvolgimento degli stakeholders.[28] In questi casi, gli accordi transattivi prevedono frequentemente la revisione delle determinazioni raggiunte utilizzando il sistema algoritmico oggetto di contestazione, nonché il riconoscimento di un ristoro economico a fronte degli effetti avversi causati dall’utilizzo di tali sistemi[29].

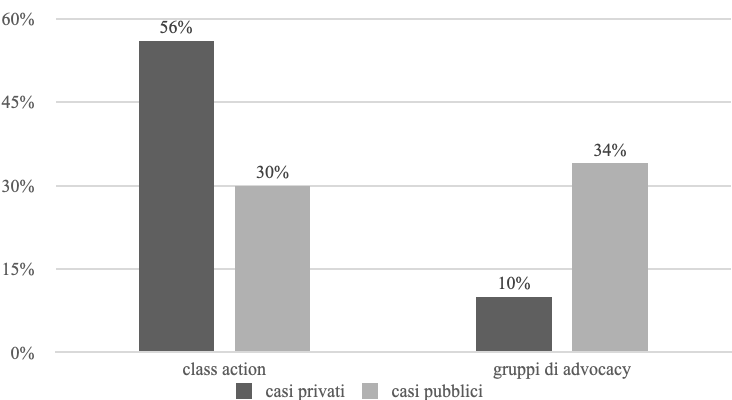

Figura 3 – Azioni collettive e gruppi di advocacy.

La Figura 3 evidenzia che oltre il 55% delle controversie tra privati sono promosse come class actions, mentre tale percentuale diminuisce al 30% per le controversie di cui è parte l’amministrazione[30]. Di contro, tale tendenza è invertita quando si considera il supporto dei gruppi di advocacy: solo il 10% delle controversie tra privati beneficia di tale forma di supporto, mentre per i casi pubblici la percentuale supera la soglia del 34%. Quali fattori possono spiegare tali differenze?

La netta prevalenza delle class actions fra i casi tra privati rispetto a quelli pubblici potrebbe essere spiegata dalla natura delle controversie e da un particolare effetto di composizione del campione. La maggior parte dei casi che coinvolgono la pubblica amministrazione (61%) è associata a procedimenti penali o attività di enforcement, spesso connessi a posizioni individuali e quindi tendenzialmente incompatibili con la presentazione di una class action[31]. Nei casi restanti, la percentuale delle controversie promosse come class action si assesta al 50%, pertanto tendenzialmente in linea con i casi tra privati (56%).

Una possibile spiegazione per il diverso ruolo giocato da gruppi di advocacy è che i ricorrenti nei casi pubblici sono tendenzialmente membri vulnerabili della società: individui a basso reddito che necessitano di sostegno sociale o assistenza economica, che vivono in aree svantaggiate, minoranze o gruppi con disabilità psicofisiche. In questi casi, il ruolo e il supporto dei gruppi di advocacy nel promuovere azioni legali e nel sostenere i costi del contenzioso sono cruciali[32]. Di contro, i ricorrenti nei casi privati sono solitamente società o soggetti con posizioni qualificate, come autori o sceneggiatori, oppure individui che sfruttano azioni specifiche, come quelle previste dal Biometric Information Privacy Act. Guardando più in dettaglio al 10% delle controversie fra privati promosse con il supporto dei gruppi di advocacy, infatti, si nota che questi casi vertono esclusivamente su utilizzi discriminatori dell’intelligenza artificiale, collegati a ricorrenti a basso reddito o gruppi tradizionalmente svantaggiati[33].

Le controversie fra privati relative al mercato delle locazioni immobiliari sono un esempio. In Louis et al. v. SafeRent, un gruppo di advocacy ha supportato i ricorrenti nell’allegare in giudizio che l’impiego di un sistema di IA da parte di una società di intermediazione immobiliare per vagliare l’affidabilità creditizia degli aspiranti affittuari violasse il Fair Housing Act. Il software di screening, infatti, prendeva in considerazione fattori come la storia creditizia e i debiti non correlati all’affitto, penalizzando in modo sproporzionato specifici gruppi di potenziali affittuari[34]. Sulla base di presupposti simili, nel caso Conn. Fair Hous. v. CoreLogic Rental, un gruppo di advocacy ha contestato in giudizio che il software di screening “CrimSAFE” effettuasse una valutazione dell’affidabilità dei potenziali affittuari sulla base dell’esistenza di precedenti penali, notificando l’esito dello screening ai proprietari degli immobili[35].

Si osserva questa tendenza anche nelle attività di selezione e reclutamento del personale. Nel 2019, l’Electronic Privacy Information Center (EPIC) ha presentato un reclamo alla Federal Trade Commission (FTC) contro una società di reclutamento, allegando l’utilizzo di pratiche discriminatorie per la profilazione dei candidati mediante l’uso di sistemi di IA per il riconoscimento delle emozioni[36]. Il reclamo evidenziava che l’impossibilità per i candidati di accedere ai dati ed ai fattori utilizzati per generare le loro valutazioni algoritmiche gli impediva di comprendere ed eventualmente contestarne il contenuto[37]. Allo stesso modo, la US Equal Employment Opportunity Commission ha contestato l’utilizzo di sistemi di IA per la selezione del personale, lamentando la produzione di effetti discriminatori su specifici gruppi di candidati, come l’esclusione automatica dei candidati più anziani sulla base della sola età anagrafica[38].

4. Casi promossi contro la pubblica amministrazione

In questa seconda parte concentro l’attenzione sulle controversie rivolte contro le amministrazioni pubbliche statunitensi. L’analisi delle 44 controversie pubbliche mi ha permesso di evidenziare che la maggioranza delle sentenze che dichiarano illegittimità dell’uso dell’IA da parte delle amministrazioni pubbliche si basano su presupposti procedurali, in particolare quelli riguardanti violazioni della due process clause. Più nello specifico, ho rilevato che le decisioni giudiziali analizzate contestano sei principali tipologie di violazioni procedurali: i. Mancanza di comunicazioni e motivazioni idonee; ii. Mancanza di rimedi di contestazione effettivi; iii. Indisponibilità delle informazioni; iv. Mancanza di meccanismi di supervisione umana; v. Mancato rispetto delle procedure di notice-and-comment; vi. Mancanza di idonee procedure di assessment.

Di contro, l’analisi mostra che le corti federali e statali non contestano la complessiva legittimità dell’utilizzo dei sistemi di IA per lo svolgimento di funzioni pubbliche, e aspetti sostanziali legati all’arbitrarietà, alla mancanza di basi scientifiche o all’irragionevolezza delle decisioni algoritmiche raramente vengono presi in considerazione[39]. A conferma di ciò, è opportuno evidenziare che nelle ipotesi in cui l’amministrazione resistente riesca a dimostrare in giudizio di aver superato le problematiche procedurali o legate alle garanzie imposte dalla due process clause, le corti tendono a dismettere il caso anche se permangono incertezze sul funzionamento e sull’effettiva affidabilità dei sistemi di IA[40].

4.1. Mancanza di comunicazioni e motivazioni idonee

L’assenza di una comunicazione chiara a sostegno delle decisioni automatizzate, insieme alla mancanza di una motivazione comprensibile per i ricorrenti, è qualificata dalle corti statunitensi come una violazione del 5 e 14 emendamento della Costituzione, nonché una violazione dell’Administrative Procedure Act[41]. Gli individui che vengono privati di interessi giuridicamente rilevanti (property o liberty interests) e protetti costituzionalmente hanno il diritto di ricevere una comunicazione che spieghi in maniera sufficientemente chiara le ragioni alla base di una decisione algoritmica sfavorevole[42]. Tali comunicazioni devono fornire informazioni dettagliate, consentendo ai soggetti interessati di vagliare la sussistenza di potenziali errori e decidere se intraprendere un’azione correttiva[43]. L’assenza di un’adeguata motivazione, infatti, non solo riduce la comprensibilità della decisione algoritmica, ma mette anche in discussione l’abilità di contestarla in giudizio, così costituendo un’autonoma violazione procedurale[44].

Inoltre, le corti riscontrano l’esistenza di una violazione della due process clause quando le comunicazioni mancano di informazioni sufficientemente dettagliate sui dati e sui sistemi algoritmici impiegati nella generazione delle decisioni sfavorevoli[45]. Questa carenza rende più difficile per gli interessati proporre appello o richiedere la correzione di decisioni erronee[46]. Da ultimo, l’assenza di idonee forme di comunicazione ricomprende anche la mancata comunicazione agli utenti circa l’utilizzo di un nuovo sistema algoritmico. L’incapacità di fornire un’adeguata informativa sull’utilizzo di tali strumenti rende gli individui meno consapevoli dell’intervenuta modifica dei criteri decisionali utilizzati dai sistemi algoritmici e meno attenti all’esistenza di potenziali errori[47]. L’assenza di idonee forme di comunicazione accresce fenomeni di allarme sociale, diminuisce la fiducia pubblica e riduce la possibilità per gli interessati di contribuire attivamente a procedure collaborative post-rilascio.

4.2. Mancanza di rimedi di contestazione effettivi

L’assenza di rimedi effettivi per la contestazione della decisione algoritmica è qualificata dalle corti come una violazione della due process clause[48]. Questa violazione procedurale può assumere varie forme e gradi di intensità. L’ipotesi più grave è l’assenza di un modo efficace per contestare gli errori a valle delle decisioni algoritmiche e risolvere le relative controversie[49].

L’incapacità di fornire ai soggetti interessati un’adeguata comunicazione sulla possibilità e le modalità di contestazione di una decisione algoritmica, così come un arco temporale adeguato alla proposizione dell’appello, costituiscono autonome forme di violazione della due process clause. Le informazioni relative alle modalità di impugnazione dovrebbero essere facilmente accessibili e chiaramente esplicitate ai soggetti sottoposti a decisioni algoritmiche. Brevità, chiarezza, accessibilità di tali comunicazioni ed informazioni dovrebbero essere sottoposte ad una valutazione preventiva da parte delle pubbliche amministrazioni, possibilmente anche avvalendosi di studi che valorizzino la user experience. Più in generale, è essenziale garantire che coloro che sono impattati da una decisione algoritmica non siano semplicemente consapevoli della loro facoltà di contestare una decisione avversa, ma abbiano il supporto ed assistenza necessari nella proposizione della procedura di contestazione[50]. Questa ricomprende anche la presenza di personale pubblico adeguatamente formato nell’assistere ed assicurare una guida effettiva agli interessati[51].

Inoltre, alcune corti hanno enfatizzato il diritto dei soggetti interessati da decisioni algoritmiche avverse di essere messi nelle condizioni economiche necessarie per poter effettivamente contestare tali decisioni. Tale aspetto risulta cruciale nei casi associati all’erogazione prestazioni e servizi, o all’identificazione di frodi nella richiesta di sussidi pubblici e benefici economici, dove l’assenza di una continuazione automatica dei sussidi economici nelle more della procedura di appello è considerata un’implicita violazione delle garanzie procedurali. Ad esempio, in Elder v. Gillespie, la Corte suprema dell’Arkansas ha autorizzato un accordo transattivo focalizzato sullo sviluppo di un nuovo sistema algoritmico in linea con specifiche garanzie procedurali, come la continuazione automatica dei benefici economici nelle more dello svolgimento della procedura di appello[52].

Infine, le corti hanno vagliato le ipotesi in cui il sistema algoritmico ha impattato negativamente gli interessati senza fornire specifici dettagli sui presupposti alla base della decisione algoritmica, sebbene tali informazioni risultino essere essenziali ai fini di una contestazione effettiva[53]. Il soddisfacimento del diritto ad una procedura di appello effettiva è intrinsecamente legato alla presenza di una comunicazione adeguata circa le ragioni alla base della decisione algoritmica[54]. Da ultimo, agli interessati è negata l’opportunità di un’effettiva contestazione della decisione algoritmica avversa se non sono adeguatamente informati circa l’utilizzo dei sistemi algoritmici, e ciò risulta particolarmente evidente nelle controversie connesse all’utilizzo di risk assessment tools, modelli di polizia predittiva o tecnologie di riconoscimento facciale utilizzati a supporto delle attività di enforcement[55].

4.3. Indisponibilità delle informazioni

L’indisponibilità di informazioni riguardanti la tipologia di algoritmo, il codice sorgente, nonché di ulteriori informazioni tecniche (quali, ad esempio, dati di addestramento, dati di convalida, dati di input, elenco dei parametri ed iperparametri di ottimizzazione) utilizzate per prendere decisioni automatizzate è frequentemente qualificata dalle corti statunitensi come una violazione delle garanzie procedurali imposte dalla due process clause[56]. Il mancato accesso a tali informazioni si riverbera sulla capacità degli interessati di avere una comprensione piena della decisione algoritmica e di fare una scelta consapevole circa l’eventuale contestazione tramite una procedura di appello o reclamo[57]. Ciò nonostante, persistono controversie in cui i difensori non hanno avuto successo nel contestare il mancato accesso a tali informazione come una violazione della due process clause[58]. Questo fenomeno è particolarmente evidente nell’ambito dei giudizi penali, soprattutto quando le parti processuali sono dei soggetti a basso reddito o gruppi di advocacy sottofinanziati[59]. Gli errori difensivi nell’eccepire l’indisponibilità di informazioni relative al sistema algoritmico ed una maggiore tendenza per le società di settore ad invocare l’esistenza di segreti industriali, anche in assenza di valide ragioni, sembrano giocare un ruolo significativo in queste contestazioni infruttuose[60].

L’approccio utilizzato dalle corti diverge riguardo alla tipologia e all’entità delle informazioni che dovrebbero essere rese disponibili agli interessati per comprendere ed eventualmente contestare una decisione algoritmica sfavorevole[61]. Ad esempio, nel caso K.W. v. Armstrong, la corte distrettuale dell’Idaho ha sottolineato la necessità di garantire l’accesso ad un ampio volume di informazioni relative alla formula algoritmica e alla documentazione tecnica correlata. Senza un accesso completo a queste informazioni, infatti, l’algoritmo rimane una black box per i beneficiari, mettendo così in discussione l’effettività del loro diritto a contestare la decisione automatizzata[62]. Di contro, in Loomis v. Wisconsin, la corte suprema del Wisconsin ha confermato che per soddisfare gli standard procedurali imposti dalla due process clause è sufficiente che l’imputato abbia avuto l’opportunità di verificare l’accuratezza delle proprie informazioni personali elaborate dall’algoritmo, ma non ha riconosciuto un corrispondente diritto a conoscere tutti i dettagli sul funzionamento del sistema algoritmico[63].

Un aspetto cruciale connesso al diritto di accesso è il diritto delle aziende private di proteggere i propri segreti industriali, in relazione al quale gli approcci interpretativi mostrati dalle corti non sono univoci[64]. In Houston Federation of Teachers v. Houston Independent School District, nonostante la prevalenza riconosciuta alla tutela del segreto commerciale, la corte distrettuale ha qualificato l’indisponibilità delle informazioni necessarie alla verifica dell’accuratezza del sistema algoritmico come una grave violazione delle garanzie minime richieste dalla due process clause. Di conseguenza, la corte ha emesso una sentenza sfavorevole all’amministrazione scolastica, vietando l’uso del sistema algoritmico da parte del distretto scolastico, al contempo non divulgando il segreto commerciale[65].

In altri casi, le corti hanno considerato che un equilibrio tra la tutela degli interessi societari ed il diritto di accesso può essere raggiunto tramite il rilascio delle informazione in subordine all’emanazione di protective orders, che insieme ai nondisclosure orders, garantiscono l’accesso documentale alle parti processuali, limitando il rischio di divulgazione[66]. Nel caso State v. Pickett, un imputato accusato di omicidio ha richiesto l’accesso al codice sorgente del software di genotipizzazione probabilistica utilizzato per condannarlo. La Corte Suprema del New Jersey ha ordinato il rilascio del codice sorgente e della documentazione correlata attraverso un protective order per garantire il diritto dell’imputato di contestare l’affidabilità del software e delle relative risultanze[67]. L’utilizzo dei protective orders mitiga il rischio che le imprese vedano divulgate informazioni confidenziali e previene possibili pregiudizi a danno delle parti processuali ricorrenti[68]. L’obiettivo di impedire ai concorrenti commerciali di sottrarre informazioni proprietarie è un obiettivo centrale della normativa in materia di tutela della proprietà intellettuale, ma non dovrebbe giustificare la violazione dei diritti garantiti dalla due process clause, sottraendo dalla conoscenza delle parti informazioni indispensabili all’esercizio del diritto di difesa[69].

Per superare la tensione tra la tutela dei segreti commerciali e la promozione del necessario accesso alle informazioni, le amministrazioni pubbliche dovrebbero sfruttare il proprio potere contrattuale, nonché altre forme di incentivi premiali[70]. Un approccio potrebbe consistere nell’includere clausole contrattuali che obblighino i fornitori privati a rendere disponibili un numero di informazioni sufficienti per rispondere alle preoccupazione dell’opinione pubblica, stabilendo già in sede contrattuale una distinzione tra informazioni da mantenere riservate ed informazioni divulgabili[71]. Inoltre, le pubbliche amministrazioni possono optare per l’acquisto esclusivo di sistemi algoritmici che garantiscano standard minimi di accessibilità[72]. Tali scelte di policy potrebbero incoraggiare lo sviluppo di sistemi di qualità complessivamente superiore ed in grado di resistere allo scrutinio processuale[73]. L’obiettivo finale non è una totale accessibilità, ma garantire l’accesso alle informazioni necessarie per garantire la tutela dei diritti coperti dalla due process clause[74], fornendo così anche alle corti le informazioni necessarie per valutare la legittimità e il corretto funzionamento del sistema algoritmico[75].

4.4. Mancanza di meccanismi di supervisione umana

L’assenza di meccanismi di supervisione umana (il c.d. “human in the loop”) – qualificati da alcune corti come una violazione procedurale – si manifesta in due forme principali. Primo, l’esclusione di qualsivoglia intervento umano nel corso del procedimento decisionale automatizzato[76]. Secondo, il diniego dell’opportunità per gli interessati di presentare il loro caso ad un impiegato pubblico o di ricevere una revisione umana prima dell’implementazione di una decisione automatizzata[77].

Nella serie di controversie legate all’utilizzo del sistema MiDAS (Michigan integrated Data Automated System) implementato dalla Unemployment Insurance Agency dello Stato del Michigan per l’identificazione di frodi nella richiesta di sussidi economici, le corti hanno censurato i casi in cui i procedimenti decisionali automatizzati sono stati svolti senza il coinvolgimento di un supervisore umano. Il sistema automatizzato MIDAS accusava i beneficiari di frodi intenzionali, rifiutando l’assegnazione del caso ad un impiegato per approfondire le discrepanze nei casi più complessi o incerti. In Zynda et al. v. Arwood, la corte distrettuale ha ordinato di sospendere tutte le attività di recupero crediti, a meno che le decisioni automatizzate non fossero esaminate singolarmente dal personale dell’agenzia e confermate con una nuova comunicazione ai beneficiari richiedenti[78]. A seguito del raggiungimento di un accordo transattivo, l’agenzia ha accettato di riesaminare tutte le determinazioni di frode effettuate dal sistema automatizzato MiDAS[79]. Successivamente, lo Stato del Michigan ha vietato l’identificazione di frodi basate esclusivamente su discrepanze individuate in modo automatico e ha disposto il coinvolgimento obbligatorio di un supervisore umano in ogni determinazione definitiva di frode, così da vigilare, identificare e correggere eventuali errori ascrivibili al sistema algoritmico[80]. In Barry v. Corrigan (Lyon), la corte distrettuale del Michigan ha censurato la mancanza di meccanismi di supervisione umana prima di escludere gruppi di beneficiari dall’accesso a forme di sussidi economici, così come l’assenza di personale pubblico a cui presentare incongruenze o potenziali errori del sistema algoritmico[81]. Da ultimo, la corte distrettuale ha proibito al Michigan Department of Health & Human Services (MDHHS) di continuare ad escludere automaticamente i beneficiari dall’accesso ai sussidi economici senza condurre ulteriori verifiche e approfondimenti sotto la supervisione di un impiegato umano.

In sostanza, le garanzie imposte dalla due process clause richiedono l’attivazione di meccanismi di supervisione umana in una fase antecedente o successiva al processo di deprivazione degli interessati. Tuttavia, è importante notare che quando un supervisore umano è coinvolto nel processo decisionale automatizzato, anche se non vi è un’effettiva garanzia sulla qualità dell’attività di supervisione svolta[82], le corti sembrano essere più inclini a limitare il proprio sindacato circa l’utilizzo dei sistemi di IA[83], con una riduzione proporzionale dell’attenzione circa l’accuratezza di tali sistemi[84]. Nonostante gli sforzi sottesi all’implementazione di politiche di supervisione umana, queste spesso si dimostrano incapaci di garantire l’eliminazione di errori e forme di discriminazione, piuttosto legittimando una riduzione del livello istituzionale di scrutinio sull’utilizzo dei sistemi di IA[85].

4.5. Mancato rispetto delle procedure di notice-and-comment

Non ci sono regole procedurali specificamente applicabili all’utilizzo dei sistemi di IA da parte della pubblica amministrazione. Tuttavia, parte della letteratura statunitense ritiene che se l’algoritmo è analogo ad una rule[86], allora le procedure di informal rulemaking di cui all’Administrative Procedure Act Federale o Statale saranno applicabili[87].

Determinare se l’adozione di un sistema algoritmico corrisponda all’adozione di una legislative rule, pertanto sottoposta alle procedure di notice-and-comment è spesso sfidante[88]. Tuttavia, quando i sistemi di IA privano un’agenzia e il suo personale dell’esercizio sostanziale della propria discrezionalità amministrativa, specialmente attraverso l’introduzione di scelte numeriche o metodologiche vincolate, l’introduzione di tali sistemi dovrebbe essere tendenzialmente considerata al pari di una legislative rule e quindi sottoposta alle procedure di notice-and-comment. Gli algoritmi che portano a decisioni sull’allocazione di benefici economici o supportano decisioni riguardanti i rapporti di lavoro possono essere considerati legislative rule, così come l’utilizzo di algoritmi che influenzano le priorità delle attività di enforcement o polizia[89].

In Ark. Dep t of Human Servs. v. Ledgerwood, la corte suprema dell’Arkansas ha confermato che l’adozione e l’implementazione di una policy ad applicabilità generale ed effetti futuri – il sistema di IA – senza fornire una adeguata comunicazione (notice) ed una significativa opportunità di partecipazione degli interessati (public comment), violava l’Administrative Procedure Act statale[90]. Pertanto, tramite l’emanazione di una injunction, la corte suprema dell’Arkansas ha vietato l’utilizzo del sistema algoritmico fino a quando non fosse stata garantita la conformità alle garanzie minime imposte dalla due process clause[91]. Allo stesso modo, in Valesaca v. Decker, la corte distrettuale di New York ha stabilito che l’introduzione di una nuova No-Release Policy – mediante l’uso di uno nuovo strumento di valutazione del rischio che sostanzialmente privava gli agenti dell’immigrazione della loro discrezionalità decisionale – senza rispettare i requisiti imposti dalla procedura di informal rulemaking fosse illegittima[92]. In questi casi, le corti statunitensi hanno censurato la mancanza di trasparenza nell’informare il pubblico sull’utilizzo di nuovi criteri decisionali o sulla modifica delle metodologie di valutazione, così come l’assenza di un’opportunità per i soggetti interessati di fornire commenti e partecipare al processo decisionale[93].

In definitiva, se l’utilizzo del sistema algoritmico ricade nella definizione di legislative rule il mancato rispetto della procedura di informal rulemaking prescritta dall’APA statale o federale può essere qualificato dalle corti come una violazione procedurale[94]. Il mancato rispetto della procedura di notice-and-comment produce effetti sul mancato coinvolgimento del pubblico nello sviluppo di sistemi di IA. L’assenza di un’ampia partecipazione nell’adozione e sviluppo di sistemi algoritmici pone diverse sfide – la partecipazione pubblica è essenziale per la legittimazione dell’attività decisionale automatizzata, per promuovere maggiore consapevolezza fra gli utenti e per aumentare la fiducia nell’utilizzo dei sistemi basati sull’IA[95].

4.6. Mancanza di idonee procedure di assessment

La mancanza di un’appropriata procedura di assessment riguardante l’introduzione ed il funzionamento di un sistema algoritmico è stata qualificata da alcune corti statunitensi come una violazione procedurale. In K.W. v. Armstrong, la corte distrettuale dell’Idaho ha censurato la mancanza di test e verifiche regolari sul corretto funzionamento della formula algoritmica da parte della pubblica amministrazione per garantire che gli outputs prodotti dal sistema di IA non riducessero arbitrariamente i budgets assistenziali dei beneficiari[96]. Più in generale, diversi autori, come Kaminski e Urban, suggeriscono che le amministrazioni pubbliche dovrebbero periodicamente assicurare lo svolgimento di attività indipendenti di audit per monitorare la presenza di forme di discriminazioni non intenzionali, allucinazioni o risultati erronei dovuti al malfunzionamento della formula algoritmica[97], e ciò anche tramite l’introduzione di specifiche clausole contrattuali in accordo con i fornitori privati[98].

Un altro aspetto rilevante legato alle procedure di assesment è l’adeguato coinvolgimento di utenti e stakeholders. Sempre in K.W. v. Armstrong – una class action intentata contro lo Stato dell’Idaho per un’illegittima riduzione dei sussidi assistenziali a seguito dell’introduzione di un nuovo sistema algoritmico – l’accordo transattivo autorizzato dalla corte ha imposto all’agenzia statale di garantire un canale continuativo di dialogo con la popolazione interessata durante lo sviluppo del nuovo sistema algoritmico[99]. Più nel dettaglio, l’agenzia è stata onerata di fornire adeguate informazioni e aggiornamenti agli utenti e gruppi di stakeholders, sollecitare attivamente il loro feedback ed incorporarlo nello sviluppo del nuovo sistema algoritmico[100]. Le pubbliche amministrazioni possono solo beneficiare dalle prospettive e competenze degli stakeholders coinvolti nello sviluppo ed implementazione dei sistemi di IA[101]. Promuovendo il coinvolgimento degli utenti e la comprensione dei modelli e relative risultanze, i sistemi algoritmici possono sfruttare questo coinvolgimento per verificare e correggere progressivamente gli outputs del sistema[102]. In breve, il coinvolgimento degli stakeholders nel processo di progettazione e sviluppo di sistemi di IA potrebbe aiutare a riconoscere le problematiche più rapidamente e in modo più sistematico[103]. Ancora una volta, fare leva sul potere contrattuale delle pubbliche amministrazioni può portare alla negoziazione di clausole contrattuali che impongono ai fornitori privati di attivare procedure di coinvolgimento di gruppi di utenti e stakeholders[104]. Come suggerito da Coglianese e Lampmann, i contratti d’appalto possono imporre agli operatori economici di partecipare attivamente nelle attività di public engagement e collaborare con le amministrazioni pubbliche nel garantire l’attivazione di apposite procedure di consultazione circa lo sviluppo del sistema algoritmico, sulla falsa riga delle procedure di “notice-and-comment”[105].

4.7. Implicazioni normative

L’analisi conduce a una principale conclusione: da un lato, le corti statunitensi non contestano la complessiva legittimità dell’utilizzo dei sistemi di IA come strumento di ausilio o supporto delle attività decisionali per lo svolgimento di funzioni pubbliche; dall’altro, le decisioni giudiziarie che dichiarano l’illegittimità dell’uso dell’IA da parte delle amministrazioni pubbliche si basano principalmente su ragioni di tipo procedurale. L’analisi ha permesso di individuare le sei principali violazioni procedurali rilevate dalle corti, in particolare connesse alle violazioni della due process clause. Di contro, gli aspetti sostanziali legati all’arbitrarietà, alla mancanza di basi scientifiche o all’irragionevolezza delle decisioni algoritmiche sono raramente prese in considerazione dalle corti.

Questa evidenza ha rilevanti implicazioni normative, sia di portata generale, relative alle ragioni che spingono le corti statunitensi a privilegiare ragioni procedurali piuttosto che sostanziali, sia specifiche, relative alle modalità di effettiva implementazione delle descritte garanzie procedurali da parte delle amministrazioni pubbliche statunitensi.

Una possibile spiegazione per la tendenza delle corti a privilegiare aspetti procedurali è che tali eccezioni sono più facilmente allegabili in giudizio[106]. Le istanze connesse a violazioni della due process clause si concentrano principalmente sull’effettivo rispetto delle regole procedurali, piuttosto che sulla ragionevolezza o sull’effettivo impatto delle decisioni algoritmiche su diversi gruppi di cittadini. Ciò rende più agevole la raccolta di elementi probatori o la formulazione di argomentazioni relative a violazione procedurali del processo decisionale automatizzato, piuttosto che dimostrarne l’impatto negativo in termini di uguaglianza o ragionevolezza. A ciò si aggiunge l’assenza di sufficienti competenze specialistiche da parte delle corti per sindacare questioni più strettamente sostanziali, nonché i maggiori costi connessi alla nomina di esperti forensi per le attività di analisi e test dei sistemi di IA sottoposti al vaglio giurisdizionale. Inoltre, l’assenza di modalità efficaci per contestare alcuni tipi di sistemi di IA, in particolare in settori come la polizia predittiva e le attività di enforcement, contribuisce alla limitata esplorazione nelle decisioni giudiziarie di aspetti sostanziali più ampi, come quelli legati all’arbitrarietà, alla mancanza di basi scientifiche o all’irragionevolezza[107].

In sostanza, le istanze connesse alla violazione di regole procedurali risultano complessivamente più agevoli da allegare in giudizio per i difensori e più facilmente sindacabili dalle corti. Tuttavia, il fatto che le decisioni giudiziarie relative all’uso di sistemi di IA si concentrino principalmente su presupposti procedurali non implica l’assenza di aspetti sostanziali. Anzi, suggerisce il contrario: le questioni sostanziali vengono tipicamente affrontate attraverso soluzioni procedurali, che consentono alle corti di affrontare indirettamente problematiche più ampie. L’effettivo impiego di garanzie procedurali può agevolare le pubbliche amministrazioni nell’affrontare problematiche sostanziali legate alla ragionevolezza ed uguaglianza delle decisioni algoritmiche. A sua volta, ciò può mitigare gli effetti negativi derivanti dall’uso di sistemi di IA e rafforzare la fiducia dell’opinione pubblica. D’altro canto, nelle ipotesi in cui l’amministrazione resistente riesca a dimostrare in giudizio di aver superato le problematiche procedurali o legate alle garanzie imposte dalla due process clause, le corti tendono a dismettere il caso anche se permangono incertezze sul funzionamento e sull’effettiva affidabilità dei sistemi di IA, evidenziandosi tutti i limiti intrinseci ad un sindacato che si limita a valorizzare esclusivamente violazioni di tipo procedurale piuttosto che sostanziale.

Sotto diverso profilo, l’identificazione delle sei violazioni procedurali non ha una valenza meramente classificatoria, ma fornisce indicazioni pratiche su come le amministrazioni pubbliche statunitensi debbano dare concreta implementazione alle garanzie procedurali necessarie a superare il vaglio giurisdizionale. In tal senso, è opportuno evidenziare che le sei violazioni procedurali risultano essere complessivamente allineate con le misure procedurali previste dal recente Executive Order 14,100 “Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence” per la protezione dei civil rights e la promozione dell’eguaglianza nell’utilizzo dei sistemi di IA da parte del governo federale. L’Executive Order individua una serie di garanzie procedurali correlate all’utilizzo dei sistemi di IA da parte del governo federale, ed in particolare: l’esistenza di informative adeguate circa l’utilizzo di sistemi di IA; l’introduzione di sistemi di audit e di verifica delle decisioni algoritmiche avverse; il mantenimento di appropriati livelli di discrezionalità decisionale in capo agli impiegati pubblici; l’implementazione di appropriate procedure di appello e assistenza da parte del personale impiegato presso le amministrazioni governative[108]. La tassonomia proposta, attraverso i casi decisi dalle corti, riempie di contenuto le indicazioni di policy elaborate a livello federale e statale, fornendo alle amministrazioni pubbliche concrete indicazioni per conformarsi al quadro regolatorie delineato dal Executive Order e da future iniziative legislative, garantendo l’esercizio di un’azione amministrativa coerente con i livelli minimi di tutela fissati a livello governativo[109].

5. Conclusioni

Le discussioni nel dibattito accademico e pubblico statunitense hanno sollevato preoccupazioni legate alle discriminazioni di genere, razziali e socioeconomiche dovute all’utilizzo di sistemi di IA da parte delle amministrazioni pubbliche[110]. Negli Stati Uniti, l’analisi di 44 controversie che coinvolgono le pubbliche amministrazioni rivela che la maggioranza delle sentenze che dichiarano illegittimità dell’uso dei sistemi di IA si basano quasi esclusivamente su presupposti procedurali. Le sei violazioni procedurali individuate e discusse in questo contributo forniscono una tassonomia dei requisiti minimi che qualsiasi ente governativo statunitense dovrebbe rispettare per far sì che l’utilizzo dei sistemi di IA superino il vaglio giurisprudenziale. Sebbene il contributo sia incentrato sugli Stati Uniti, l’approccio concreto e casistico delle corti statunitensi fornisce indicazioni utili per capire in che direzione le corti potrebbero muoversi anche in Europa e in Italia, pur alla luce di un quadro regolatorio differente. In ultima analisi, l’articolo sottolinea il ruolo cruciale che i giudici possono svolgere nel plasmare documenti politici e nel guidare gli enti governativi nel complesso panorama dello sviluppo dei sistemi di intelligenza artificiale[111].

- In tal senso, C. Coglianese, Administrative Law in the Automated State, in Daedalus, 2021, pp. 106-107; D.K. Citron, Technological Due Process, in Washington University Law Review, 2008, pp. 1251-1252. ↑

- Cfr. C. Coglianese, L. M. Ben Dor, AI in Adjudication and Administration, in Brooklyn Law Review, 2020, p. 814. ↑

- In argomento, si veda D.K. Citron, F. Pasquale, The Scored Society: Due Process for Automated Predictions, in Washington University Law Review, 2014, pp. 13-16; K. Crawford, J. Schultz, Big Data and Due Process: Toward A Framework to Redress Predictive Privacy Harms, in Boston College Law Review, 2014, pp. 99-101; S. Barocas, A.D. Selbst, Big Data’s Disparate Impact, in California Law Review, 2016, pp. 673-674; R. Calo, D.K. Citron, The Automated Administrative State: A Crisis of Legitimacy, in Emory Law Journal, 2021, p. 800. Nell’ambito della letteratura italiana, tra gli altri, si veda A. Simoncini, L’algoritmo incostituzionale: intelligenza artificiale e il futuro delle libertà, in BioLaw Journal, 2019, pp. 63 ss.; F. Costantino, Rischi o opportunità del ricorso delle amministrazioni alle predizioni dei big data, in Dir. Pubbl., 2019, pp. 43 ss.; N. Rangone, Intelligenza artificiale e pubbliche amministrazioni: affrontare i numerosi rischi per trarne tutti i vantaggi, in BioLaw Journal, 2022, pp. 472 ss. Per un recente lavoro monografico, in argomento si veda E. Falletti, Discriminazione algoritmica. Una prospettiva comparata, Giappichelli, Torino, 2022. ↑

- Promoting the Use of Trustworthy Artificial Intelligence in the Federal Government, Exec. Order No. 13,960, 85 Fed. Reg. 78,939 (Dec. 3, 2020). ↑

- The White House, Blueprint for an AI Bill of Rights: Making Automated Systems Work for the American People, (Oct. 4, 2022), https://www.whitehouse.gov/ostp/ai-bill-of-rights/ (Il white paper identifica cinque principi non vincolanti per minimizzare i potenziali danni derivanti da alcuni utilizzi dell’IA: «save and effective systems; algorithmic discrimination protections; data privacy; notice and explanation; human alternatives, consideration, and fallback»). In argomento, cfr. E. Hine, L. Floridi, The Blueprint for an AI Bill of Rights: In Search of Enaction, at Risk of Inaction, in Minds and Machines, 2023, pp. 285 ss. ↑

- Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence, Exec. Order No. 14,110, 88 Fed. Reg. 75,191 (Oct. 30, 2023). Più di recente, la Casa Bianca ha rilasciato un memorandum che individua una serie obblighi a carico delle agenzie federali per fronteggiare i rischi derivanti dall’impiego governativo dell’IA. Cfr. Executive Office of the President, Advancing Governance, Innovation, and Risk Management for Agency Use of Artificial Intelligence, (Mar. 28, 2024), https://www.whitehouse.gov/wp-content/uploads/2024/03/M-24-10-Advancing-Governance-Innovation-and-Risk-Management-for-Agency-Use-of-Artificial-Intelligence.pdf. ↑

- E. K. Cortez, N. Maslej, Adjudication of Artificial Intelligence and Automated Decision-Making Cases in Europe and the USA, in European Journal of Risk Regulation, 2023, pp. 457-458; R. Calo, D.K. Citron, The Automated Administrative State: A Crisis of Legitimacy, cit., pp. 818-832; C. Coglianese, L.M. Ben Dor, AI in Adjudication and Administration, cit., pp. 833; H. Bloch-Wehba, Access to Algorithms, in Fordham Law Review, 2020, p. 1267; A. Z. Huq, Constitutional Rights in the Machine-Learning State, in Cornell Law Review, 2020, pp. 1895-1897; R. Richardson, J. M. Schultz,, V. M. Southerland, Litigating Algorithms 2019 US Report: New Challenges to Government Use of Algorithmic Decision Systems, AI Now Institute, 2019, consultabile alla pagina https://ainowinstitute.org/wp-content/uploads/2023/04/litigatingalgorithms-2019-us.pdf; Litigating Algorithms: challenging government use of algorithmic decision systems, AI Now Institute, 2018, consultabile alla pagina https://ainowinstitute.org/publication/litigating-algorithms-3. ↑

- L’Unione Europea, come noto, ha posto l’attenzione sullo sviluppo di un’agenda politica (focalizzata sull’approvazione di un quadro regolatorio uniforme sull’Intelligenza Artificiale) finalizzata a mitigare gli effetti negativi legati all’utilizzo dei sistemi di IA. In tal senso, si veda il recente Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, pubblicato in GUUE il 12 luglio 2024, che stabilisce regole armonizzate sull’intelligenza artificiale (il c.d. “Artificial Intelligence Act”). Con riferimento alla diversità degli approcci adottati dall’Unione Europea e dagli Stati Uniti per la regolazione dell’IA si veda, E. Chiti, B. Marchetti, Divergenti? Le strategie di Unione europea e Stati Uniti in materia di intelligenza artificiale, in Rivista della regolazione dei mercati, 2020, pp. 29 ss. In argomento, anche A. Simoncini, Verso la regolamentazione della Intelligenza Artificiale. Dimensioni e governo, in BioLaw Journal, 2, 2021, p. 413; S. Aceto di Capriglia, Intelligenza artificiale: una sfida globale tra rischi, prospettive e responsabilità. Le soluzioni assunte dai governi unionale, statunitense e sinico. Uno studio comparato, in Federalismi.it, 2024, pp. 22 ss.. ↑

- L’ultimo accesso al database è avvenuto in data 01/12/2023, per un totale di 100 casi. Tuttavia, nove casi sono stati esclusi poiché riguardavano controversie non istaurate negli Stati Uniti, controversie antecedenti al 2010 o controversie valutate come non rilevanti per lo scopo della presente analisi. I dati sono accessibili alla pagina https://blogs.gwu.edu/law-eti/ai-litigation-database-search. ↑

- L’ultimo accesso al database è avvenuto il 01/12/2023. La selezione degli ulteriori 37 casi è stata effettuata tramite l’iniziale utilizzo del filtro di ricerca “lawsuit filing/litigation”, seguita da un’analisi puntuale dei casi così individuati. I dati sono accessibili alla pagina https://www.aiaaic.org/aiaaic-repository. ↑

- In via esemplificativa, l’AI Index Report 2023, promosso dalla Stanford University, identifica nel 2022 un totale di 110 casi giudiziari correlati all’utilizzo dell’IA. Tuttavia, lo studio riconosce che alcune delle controversie conteggiate potrebbero non affrontare direttamente questioni legate all’effettivo impiego dell’IA, basandosi solo su un filtro di ricerca per parole chiave, come “artificial intelligence”, “machine learning”, e “automated decision-making”. Cfr. N. Maslej et al., The AI Index 2023 Annual Report, AI Index Steering Committee, Institute for human-centered AI, Stanford University, 2023, pp. 291-295, consultabile alla pagina https://aiindex.stanford.edu/wp-content/uploads/2023/04/HAI_AI-Index-Report_2023.pdf. ↑

- Sono stati classificati come “conclusi” tutti i contenziosi con almeno una decisione di primo grado e non attualmente sottoposti ad un giudizio di appello. Sono stati considerati come “accordi transattivi” i contenziosi conclusi con un accordo transattivo autorizzato dalla corte, oppure quelli in cui l’accordo stragiudiziale è richiamato dalla corte per dichiarare la cessazione della materia del contendere. Infine, sono stati classificati come “pendenti” i giudizi ancora in corso di svolgimento. ↑

- Nel panorama italiana, con specifico riguardo all’uso di algoritmi e intelligenza artificiale nell’assunzione delle decisioni amministrative, fra gli altri, si veda M. Macchia, A. Mascolo, Intelligenza artificiale e sfera pubblica: lo stato dell’arte, in Giorn. dir. amm., 2022, pp. 556 ss.; P. Otranto, Riflessioni in tema di decisione amministrativa algoritmica, intelligenza artificiale e legalità, in Federalismi.it, 2021, pp. 187 ss.; R. Cavallo Perin, Ragionando come se la digitalizzazione fosse data, in Dir. amm., 2020, pp. 305 ss.; S. Civitarese Matteucci, «Umano troppo umano». Decisioni amministrative automatizzate e principio di legalità, in Dir. pubbl., 2019, pp. 5 ss.; E. Picozza, Intelligenza artificiale e diritto, in Giur. It., 2019, pp. 1761 ss.; G. Avanzini, Decisioni amministrative e algoritmi informatici. Predeterminazione analisi predittiva e nuove forme di intelligibilità, Editoriale Scientifica, Napoli, 2019. ↑

- I casi legati all’uso discriminatorio dell’IA nei processi di reclutamento dei lavoratori, nell’intermediazione immobiliari o nella vendita di prodotti finanziari per i consumatori, e che spesso comportano l’assegnazione di punteggi più bassi a gruppi tradizionalmente più svantaggiati, costituiscono un’eccezione. ↑

- American civil liberties v. Clearview AI, Inc., No. 2020-CH-04353 (Ill. Cir. Ct. May 28, 2020); Calderon v. Clearview AI, Inc., No. 1:20-cv-01296, (S.D.N.Y. Feb 13, 2020); Broccolino v. Clearview AI, Inc., No. 1:20-cv-02222, (S.D.N.Y. Mar 12, 2020); Burke et al. v. Clearview AI, Inc. et al, No. 1:20-cv-03104 (S.D.N.Y. Apr 17, 2020); Hall v. CDW Government LLC et al, No. 1:20-cv-00846 (N.D. Ill. Feb 05, 2020); John et al v. Clearview AI, Inc., No. 1:20-cv-03481, (S.D.N.Y. May 04, 2020); Marron et al v. Clearview AI, Inc., No. 1:20-cv-02989, (N.D. Ill. May 20, 2020); McPherson v. Clearview AI, Inc. et al, No. 1:20-cv-03053, (S.D.N.Y. Apr 15, 2020); Mutnick v. Clearview AI, Inc., No. 1:20-cv-00512, (N.D. Ill. Jan 22, 2020); Carmean v. Macy’s Retail Holdings, Inc., No. 1:20-cv-04589, (N.D. Ill. Aug 05, 2020); Roberson v Clearview AI, Inc., No. 1:20-cv-00111, (E.D. Va. Feb 02, 2020); Thornley v. Clearview AI, Inc., No. 1:20-cv-03843, (N.D. Ill. Jun 30, 2020); State v. Clearview AI, Inc., No. 226-3-20 (Vt. Super. Ct. Mar 10, 2020). ↑

- A differenza di altre legislazioni sulla privacy, il BIPA riconosce ai titolari dei dati il diritto ad agire in giudizio quando i propri dati biometrici siano scansionati e raccolti in violazione del BIPA, con una liquidazione dei danni cha va da $1.000 per violazioni dovute a negligenza a $5.000 per violazioni intenzionali. Nel 2019, l’Illinois Supreme Court, nel caso Rosenbach v. Six Flags Entertainment Corp., ha stabilito che la parte ricorrente può essere automaticamente qualificata come «aggrieved person» (soggetto danneggiato), ai sensi del BIPA, senza la necessità di provare in giudizio l’esistenza di un danno effettivo, determinando così un aumento delle relative controversie. Cfr. Bloomberg Law, Is biometric information protected by Privacy Laws?, (2023), https://pro.bloomberglaw.com/insights/privacy/biometric-data-privacy-laws/; J.M. Schultz, The Right of Publicity: A New Framework for Regulating Facial Recognition, in Brooklyn Law Review, 2023, p. 1039; W. Hartzog, BIPA: The Most Important Biometric Privacy Law in the US?, in A. Kak (a cura di), Regulating biometrics: global approaches and urgent questions, AI Now Institute, September 2020, pp. 96-100. ↑

- Carpenter v. McDonald’s Corporation, No. 1:21-cv-02906 (N.D. Ill. May 28, 2021); Rodriguez Perez v. Amazon.com, Inc., No. 1:23-cv-02251 (S.D.N.Y. Mar 16, 2023); McCall v. Amazon.com Services LLC, No. 1:23-cv-00901 (S.D.N.Y. Feb 02, 2023); Bah v. Apple Inc. et al, No. 2:20-cv-15018 (D.N.J. Oct 27, 2020); Bah v. Apple Inc. et al, No. 1:19-cv-03539 (S.D.N.Y. Apr 22, 2019). ↑

- Cfr. T. et al v. OpenAI, LP et al, No. 3:23-cv-04557 (N.D. Cal. Sep 05, 2023); Authors Guild et al v. OpenAI, Inc. et al, No. 1:23-cv-08292 (S.D.N.Y. Sep 19, 2023); Chabon et al v. OpenAI, Inc. et al, No. 3:23-cv-04625 (N.D. Cal. Sep. 08 2023); P.M. et al v. OpenAI LP et al, No. 3:23-cv-03199, (N.D. Cal. Jun 28, 2023); Silverman et al v. OpenAI, Inc. et al, No. 3:23-cv-03416, (N.D. Cal. Jul 07, 2023); Tremblay et al v. OpenAI, Inc. et al, No. 3:23-cv-03223, (N.D. Cal. Jul 28, 2023); Walters v. OpenAI, L.L.C., No. 1:23-cv-03122, (N.D. Ga. Jul 14, 2023); DOE 1 et al v. GitHub, Inc., No. 4:22-cv-06823 (N.D. Cal. Nov 03, 2022). Per una sommaria descrizione dei casi e delle principali questioni giuridiche, si veda J. Gillham, OpenAI ang ChatGPT lawsuit list, in Originality.AI, 2024, consultabile alla pagina https://originality.ai/blog/openai-chatgpt-lawsuit-list. ↑

- Chabon et al v. Meta Platforms Inc., No. 3:23-cv-04663, (N.D. Cal. Sep 12, 2023); Concord Music Group, Inc. et al v. Anthropic PBC, No. 3:23-cv-01092, (M.D. Tenn. Oct 18, 2023); Getty Images (US), Inc. v. Stability AI, Inc., No. 1:23-cv-00135, (D. Del. Feb 03, 2023); Huckabee et al v. Meta Platforms Inc. et al, No. 1:23-cv-09152, (S.D.N.Y. Oct 17, 2023); Kadrey et al v. Meta Platforms, Inc., No. 3:23-cv-03417 (N.D. Cal. Jul 07, 2023); L. et al v. Alphabet Inc. et al, No. 3:23-cv-03440, (N.D. Cal. Jul 11, 2023). ↑

- A. Z. Huq, Constitutional Rights in the Machine-Learning State, cit., p. 1940. ↑

- Hous. Fed’n of Teachers v. Hous. Indep. Sch. Dist., 251 F. Supp. 3d 1168, (S.D. Tex. 2017); Matter of Lederman v. King, 47 N.Y.S.3d 838 (Sup. Ct. 2016); si veda, R. Richardson, J. M. Schultz, V. M. Southerland, Litigating Algorithms 2019 US Report, cit., pp. 10-12; State of N.M. ex rel. Stewart, et al. v. Public Education Department, No. D-101-cv-2015-00409, (N.M. Ct. App.); cfr. anche, EducationWeek, Teacher Evaluation Heads to the Courts, 2023, in https://www.edweek.org/policy-politics/teacher-evaluation-heads-to-the-courts. ↑

- State v. Loomis, 2016 WI 68, 371 Wis. 2d 235, 881 N.W.2d 749; Flores v. Stanford, No. 7:18-cv-02468, (S.D.N.Y. Mar 20, 2018); Henderson v. Stensberg, No. 3:18-cv-00555 (W.D. Wis. Jul 16, 2018), Complaint; People v. Younglove, No. 341901, (Mich. Ct. App. Jan. 11, 2018). In argomento, si veda D. Kehl, P. Guo, S. Kessler, Algorithms in the Criminal Justice System: Assessing the Use of Risk Assessments in Sentencing, in Responsive Communities Initiative, Berkman Klein Center for Internet & Society, Harvard Law School, 2017, consultabile alla pagine http://nrs.harvard.edu/urn-3:HUL.InstRepos:3374604; S.B. Starr, Evidence-Based Sentencing and the Scientific Rationalization of Discrimination, in Stanford Law Review, 2014, p. 812; A.L. Washington, How to argue with an algorithm: Lessons from the COMPAS-ProPublica debate, in Colorado Technology Law Journal, 2018, p. 131; A. G. Ferguson, Policing Predictive Policing, in Washington University Law Review, 2017, pp. 1120-1223; A. Z. Huq, Racial equity in algorithmic criminal justice, in Duke Law Journal, 2019, p. 1081. ↑

- Fernandez v. CoreLogic Credco, LLC, No. 3:20-cv-01262, (S.D. Cal. Jul 06, 2020); Brown v. CoreLogic Rental Property Solutions, LLC, No. 3:20-cv-00363, (E.D. Va. May 21, 2020); Feliciano v. CoreLogic SafeRent, LLC, No. 1:17-cv-05507, (S.D.N.Y. Jul 19, 2017); Chris Robinson v. TransUnion Rental Screening Solutions, Inc., No. 8:19-cv-01994, (C.D. Cal. Oct 18, 2019); In Re: TransUnion Rental Screening Solutions FCRA Litigation, No. 1:20-md-02933 (N.D. Ga. Apr 27, 2020); Conn. Fair Hous. Ctr. v. CoreLogic Rental Prop. Sols., LLC, No. 3:18-cv-705, 2023 BL 248295, (D. Conn. July 20, 2023); Louis et al v. SafeRent Solutions, LLC et al, No. 1:22-cv-10800 (D. Mass. May 25, 2022). In argomento, si veda K. Johnson, Algorithms Allegedly Penalized Black Renters. The US Government Is Watching, in Wired, 2023, consultabile alla pagina https://www.wired.com/story/algorithms-allegedly-penalized-black-renters-the-us-government-is-watching/; R. Burns, Artificial Intelligence Is Making The Housing Crisis Worse, in The Lever, 2023, consultabile alla pagina https://www.levernews.com/artificial-intelligence-is-making-the-housing-crisis-worse/; E. Smith, H. Vogell, How Your Shadow Credit Score Could Decide Whether You Get an Apartment, in Propublica, 2022, consultabile alla pagina https://www.propublica.org/article/how-your-shadow-credit-score-could-decide-whether-you-get-an-apartment. ↑

- District of Columbia v. RealPage, Inc., et al., No. 2023-CAB-006762 (D.C. Super. Ct. Nov 01, 2023); Bason et al v. RealPage, Inc. et al., No. 3:22-cv-01611, (S.D. Cal. Oct 18, 2022). In argomento, cfr. G. Bortolotti, Algorithmic Collusion in the Housing Market, in Promarket, 2023, consultabile alla pagina https://www.promarket.org/2023/05/30/algorithmic-collusion-in-the-housing-market/; H. Vogell, Rent Going Up? One Company’s Algorithm Could Be Why, in Propublica, 2023, consultabile alla pagina https://www.propublica.org/article/yieldstar-rent-increase-realpage-rent. ↑

- Entrambe queste proporzioni riflettono l’andamento temporale delle controversie nel tempo. ↑

- Carmean v. Macy’s Retail Holdings, Inc., No. 1:20-cv-04589, (N.D. Ill. Mar. 16, 2021), Notice of voluntary dismissal without prejudice; McCall v. Amazon.com Services LLC, No. 1:23-cv-00901 (S.D.N.Y. Apr 24, 2023), Notice of voluntary dismissal without prejudice; Rodriguez Perez v. Amazon.com, Inc., No. 1:23-cv-02251 (S.D.N.Y. Jun 09, 2023), Notice of voluntary dismissal without prejudice; Jacobs Leroy v. Walgreen Company, No. 2020-CH-06118 (Ill. Cir. Ct. Aug. 17, 2021), Notice of voluntary dismissal; Van Pelt v. Cigna Group et al, No. 3:23-cv-01135, (D. Conn. Nov 7, 2023), Notice of voluntary dismissal without prejudice; Hudson, Shawn v. Tesla, Inc et al., No. 2018-CA-011812-O (Fla. 9th Jud. Cir., Apr 29, 2021), Notice of voluntary dismissal without prejudice. ↑

- Carpenter v. McDonald’s Corporation, No. 1:21-cv-02906 (N.D. Ill. Jul 12, 2023); Nilsson v. General Motors LLC, No. 4:18-cv-00471, (N.D. Cal. Jun 26, 2018), Stipulation of voluntary dismissal with prejudice; Bah v. Apple Inc. et al, No. 2:20-cv-15018 (D.N.J. Dec 27, 2021), Stipulation of voluntary dismissal with prejudice; See also, Bah v. Apple Inc. et al, No. 1:19-cv-03539 (S.D.N.Y. Dec 17, 2021), Stipulation of voluntary dismissal with prejudice. ↑

- K.W. v. Armstrong, No. 1:12-cv-00022 (D. Idaho Jan. 12, 2017), Settlement agreement; C.S. et al v. Saiki et al, No. 6:17-cv-00564 (D. Or. Jun 2, 2017), Joint Report to the Court; Elder v. Gillespie, No. 3:19-cv-00155 (E.D. Ark. Jul 18, 2023), Settlement agreement. ↑

- Zynda et al v. Arwood et al, No. 2:15-cv-11449 (E.D. Mich. Feb 02, 2017), Settlement agreement; Berliner Eric vs. Nassau County, No. 605904/2019 (N.Y. Sup Ct. Oct 14, 2020), Settlement agreement; Velesaca v. Decker, No. 1:20-cv-01803 (S.D.N.Y. Oct 03, 2022), Settlement agreement; Houston Federation of Teachers Local 2415 et al v. Houston Independent School District, No. 4:14-cv-01189 (S.D. Tex. Oct 10, 2017), Settlement agreement. ↑

- Sono state classificati come class actions sia i giudizi già certificati come tali dalle corti, sia i giudizi che sono stati instaurati come class actions ma che rimangono in attesa di una certificazione da parte della corte. ↑

- A.S. Zimmerman, D.M. Jaros, The criminal class action, in University of Pennsylvania Law Review, 2011, p. 1390 (laddove evidenzia che «Criminal procedure does not have a class action rule, like Rule 23 of the Federal Rules of Civil Procedure, in part because of the due process concerns that aggregating criminal cases generally raises. For example, each criminal defendant enjoys a personal right to decide whether to enter a plea, testify, or cross-examine witnesses»). ↑

- In tal senso, J. Villasenor, V. Foggo, Artificial Intelligence, due process, and criminal sentencing, in Michigan State Law Review, 2020, p. 345; C.H. Brown, How an algorithm kicks small businesses out of the food stamps program on dubious fraud charges, in The Intercept, 2018, consultabile alla pagina https://theintercept.com/2018/10/08/food-stamps-snap-program-usda/. ↑

- L’aumento dell’uso di sistemi di IA nel settore dell’intermediazione immobiliare, nelle procedure di reclutamento del personale o nel settore dei prodotti finanziari per i consumatori ha dato origine a diverse controversie giudiziarie fondate sull’esistenza di pratiche discriminatorie contro ricorrenti a basso reddito e gruppi tradizionalmente svantaggiati. In tal senso, D.K. Citron, F. Pasquale, The Scored Society: Due Process for Automated Predictions, cit., pp. 13-16; K. Crawford, J. Schultz, Big Data and Due Process: Toward A Framework to Redress Predictive Privacy Harms, cit., pp. 99-101; S. Barocas, A.D. Selbst, Big Data’s Disparate Impact, cit., pp. 673-674. ↑

- Louis et al. v. SafeRent Solutions LLC, No. Case 1:22-cv-10800-AK (Mass. Dist. Ct. Jan. 9, 2023). In argomento, cfr. Department of Justice, Press Release, Justice Department Files Statement of Interest in Fair Housing Act Case Alleging Unlawful Algorithm-Based Tenant Screening Practices, 2023, consultabile alla pagina https://www.justice.gov/opa/pr/justice-department-files-statement-interest-fair-housing-act-case-alleging-unlawful-algorithm; Cathy O’Neil, Holli Sargeant, Jacob Appel, Explainable Fairness in Regulatory Algorithmic Auditing, 2023, consultabile alla pagina https://ssrn.com/abstract=4598305. ↑

- Cfr. Conn. Fair Hous. Ctr. v. Corelogic Rental Prop. Sols., LLC, No. 3:18-cv-705-VLB, 2023 BL 248295 (D. Conn. July 20, 2023); National Fair Housing Alliance et al v. Facebook, No. 1:18-cv-02689, (S.D.N.Y. Mar 27, 2018). In tal senso, si veda C. Lecher, Automated background checks are deciding who’s fit for a home, in Verge, 2019, consultabile alla pagina https://www.theverge.com/2019/2/1/18205174/automation-background-check-criminal-records-corelogic. ↑

- The Electronic Privacy Information Center, In the Matter of HireVue Inc. (2019), https://epic.org/privacy/ftc/hirevue/EPIC_FTC_HireVue_Complaint.pdf. Cfr. anche Baker v. CVS Health Corp., No. 23-11483, 2024 BL 51726, (D. Mass. Feb. 16, 2024); Mobley v. Workday, Inc., No. 3:23-cv-00770 (N.D. Cal. Feb 21, 2023). ↑

- D. Harwell, A face-scanning algorithm increasingly decides whether you deserve the job, in The Washington Post, 2019, consultabile alla pagina https://www.washingtonpost.com/technology/2019/10/22/ai-hiring-face-scanning-algorithm-increasingly-decides-whether-you-deserve-job/; R. Abraham, Business Lobby Tries to Weaken Law Regulating Bias in Hiring Algorithms, in Vice, 2023, consultabile alla pagina https://www.vice.com/en/article/n7ejn8/business-lobby-tries-to-weaken-law-regulating-bias-in-hiring-algorithms; M. Varner, Public Agencies Are Buying Up AI-Driven Hiring Tools and “Bossware”, in The Markup, 2021, consultabile alla pagina https://themarkup.org/news/2021/12/23/public-agencies-are-buying-up-ai-driven-hiring-tools-and-bossware. ↑

- Equal Employment Opportunity Commission v. iTutorGroup, Inc. et al, No. 1:22-cv-02565, (E.D.N.Y May 05, 2022). Cfr. U.S. Equal Employment Opportunity Commission, Press Release, EEOC Sues iTutorGroup for Age Discrimination, 2022, consultabile alla pagina https://www.eeoc.gov/newsroom/eeoc-sues-itutorgroup-age-discrimination. ↑

- Nel corso dell’analisi, sono stati rintracciati solo pochi casi in cui le corti hanno approfondito aspetti sostanziali riguardanti l’utilizzo dei sistemi algoritmici; tuttavia, queste argomentazioni non risultano mai fondanti nel determinare l’esito della controversia. In tal senso, ad esempio, si veda Hous. Fed’n of Teachers v. Hous. Indep. Sch. Dist., 251 F. Supp. 3d 1168, 1182 (S.D. Tex. 2017) («plaintiffs offer up numerous other ways in which EVAAS falls short. Even accepting plaintiffs’ criticisms at face value, the loose constitutional standard of rationality allows governments to use blunt tools which may produce only marginal results»); People v. Wakefield, 107 N.Y.S.3d 487, 499 (App. Div. 3d Dep’t 2019) (pur respingendo l’eccezione circa l’intervenuta violazione della due process clause sulla base di specifici elementi fattuali, la corte ha riconosciuto che l’utilizzo del sistema algoritmico solleva valide preoccupazioni in merito al rapporto tra giusto procedimento e intelligenza artificiale). ↑

- Michael T. v. Bowling, No. 2:15-cv-09655, 2018 BL 103935, at *11-15 (S.D.W. Va. Mar. 26, 2018) («A review of the new authorization system reveals that the proposal does not appear to suffer from similar due process infirmities and, therefore, does not promote the injustices that this Court’s injunction was designed to remedy (…) Thus, Plaintiffs’ argument that the new authorization system will decrease their I/DD Waiver Program budgets across the board, cannot be the focus – regardless of its truth – in deciding whether to modify or vacate the current injunction, which was based in part on a finding that Plaintiffs were likely to succeed on their claim under procedural due process»). In tal senso, si veda anche Ark. Dep’t of Human Servs. v. Ledgerwood, 2019 Ark. 121, 571 S.W.3d 911, 915. ↑

- In tal senso, D.K. Citron, Technological Due Process, cit., pp. 1281-1282; D.K. Citron, F. Pasquale, The Scored Society: Due Process for Automated Predictions, cit., pp. 27-28; K. Crawford, J. Schultz, Big Data and Due Process, cit., pp. 111-117; C. Coglianese, D. Lehr, Regulating by Robot: Administrative Decision Making in the Machine-Learning Era, in Georgetown Law Journal, 2017, pp. 1185-1186. ↑

- K.W. ex rel. D.W. v. Armstrong, 180 F. Supp. 3d 703, 715 (D. Idaho 2016); Cahoo v. Fast Enters. LLC, 528 F. Supp. 3d 719, 759 (E.D. Mich. 2021); Bauserman v. Unemployment Ins. Agency, No. 333181, 2017 BL 248603, *8 (Mich. Ct. App. July 18, 2017); Perdue v. Gargano, 964 N.E.2d 825, 845 (Ind. 2012). ↑

- Perdue v. Gargano, 964 N.E.2d 825, 838 (Ind. 2012); Barry v. Corrigan (Lyon), 79 F. Supp. 3d 712, 743-744 (E.D. Mich. 2015). Cfr. anche, D.K. Citron, Technological Due Process, cit., p. 1305. In argomento, cfr. Anche D.U. Galetta, J. G. Corvalàn, Intelligenza Artificiale per una Pubblica Amministrazione 4.0? Potenzialità, rischi e sfide della rivoluzione tecnologica in atto, in Federalismi.it, 2019, p. 20-21; G. Carullo, Decisioni amministrative e intelligenza artificiale, in Dir. informaz. e inf.,., 3, 2021, pp. 431-461. ↑

- Michael T. v. Bowling, No. 2:15-cv-09655, 2016 BL 298070, *11 (S.D.W. Va. Sept. 13, 2016); Cahoo v. Fast Enters. LLC, 528 F. Supp. 3d 719, 758 – 760 (E.D. Mich. 2021); Elder v. Gillespie, 54 F.4th 1055, 1065 (8th Cir. 2022). Cfr. anche C.S. et al v. Saiki et al, Docket No. 6:17-cv-00564 (D. Or. Apr 10, 2017). ↑

- Hous. Fed’n of Teachers Local 2415 v. Hous. Indep. Sch. Dist., 251 F. Supp. 3d 1168, 1180 (S.D. Tex. 2017). Michael T. v. Bowling, No. 2:15-cv-09655, 2016 BL 298070, *11 (S.D.W. Va. Sept. 13, 2016). ↑

- M.E. Kaminski, J.M. Urban, The Right to Contest AI, in Columbia Law Review, 2021, p. 2035; H. Bloch-Wehba, Access to Algorithms, cit., p. 1290. ↑

- R. Richardson, J. M. Schultz, V. M. Southerland, Litigating Algorithms 2019 US Report, cit., p. 7; K. Crawford, J. Schultz, AI Systems as State Actors, in Columbia Law Review, 2019, pp. 1949-1950; D.F. Engstrom, D.E. Ho, Algorithmic Accountability in the Administrative State, in Yale Journal on Regulation, 2020, pp. 841-842. ↑

- M.E. Kaminski, J.M. Urban, The Right to Contest AI, cit., p. 1988. ↑

- Barry v. Corrigan (Lyon), 79 F. Supp. 3d 712, 744 (E.D. Mich. 2015). ↑

- K.W. ex rel. D.W. v. Armstrong, 180 F. Supp. 3d 703, 716 (D. Idaho 2016). ↑

- Barry v. Corrigan (Lyon), 79 F. Supp. 3d 712, 743 (E.D. Mich. 2015). Si veda anche K. Crawford, J. Schultz, AI Systems as State Actors, cit., pp. 1848-1949. ↑